Instagram wirbt für KI-Apps, die gefälschte Nacktbilder erstellen – laut aktueller Recherche

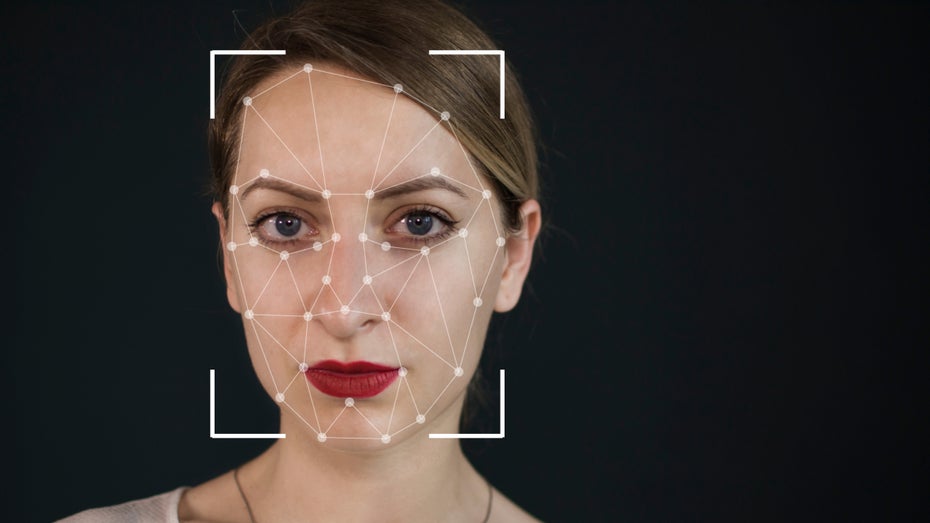

Deepfakes können zur Gefahr der Demütigung werden. (Foto: Shutterstock/Mihai Surdu)

Wie die Onlinepublikation 404 Media, die sich vorwiegend mit heiklen Themen befasst, herausgefunden hat, führt Meta – die Muttergesellschaft von Facebook und Instagram – in ihrer Anzeigenbibliothek mehrere Werbeeinträge für sogenannte „Nudify“-Apps. Die versprechen, unter Verwendung von KI, aus Fotos von Bekleideten gefälschte Nacktbilder zu machen.

Meta erkennt unzulässige Werbung oft nur durch Hinweise

Eine der Anzeigen zeigte ein Foto von Kim Kardashian neben den Worten „Ziehe jedes Mädchen kostenlos aus“. Eine andere Anzeige stellte zwei KI-generierte Fotos eines jung aussehenden Mädchens nebeneinander. Auf dem einen trug es eine langärmlige Bluse, auf dem anderen schien es oben ohne zu sein, wobei die Worte „Any clothing delete“ (etwa: Entferne jede Bekleidung) die Brüste bedecken.

Nackt-KI-Apps haben schon in vielen Fällen ihr problematisches Potenzial gezeigt. Besonders an Schulen waren sie verwendet worden, um gefälschte Nacktbilder von Teenagern zu generieren. Das hatte zu Untersuchungen und Gesetzesvorschlägen geführt, die darauf abzielten, Kinder vor solch schädlichen KI-Anwendungen zu schützen.

Anzeigen immer wieder Ausgangspunkt der Nutzung

Laut Vice hatten Schüler in Washington die Nackt-KI, mit der sie gefälschte Nacktbilder ihrer Klassenkamerad:innen erstellten, über Tiktok-Anzeigen gefunden. 404 Media hatte zwar herausgefunden, dass viele der kritischen Anzeigen bereits aus der Meta-Anzeigenbibliothek entfernt worden waren. Dennoch mussten auch etliche noch händisch von Meta gelöscht werden.

Verschärft wird die Problematik durch das hohe Kontaktpotenzial dessen, was auf Instagram gezeigt wird. Laut einer letztjährigen Umfrage geben immer noch 50 Prozent der US-Teenager an, die Social-Media-App täglich zu nutzen.