Der Einsatz von KI bietet große Chancen im Kampf gegen den Klimawandel. Warum dazu auch die Nachhaltigkeit von KI selbst gehört, erklärt Tech-Ethikerin Aimee van Wynsberghe. (Abbildung: Maria Rivera Espinosa)

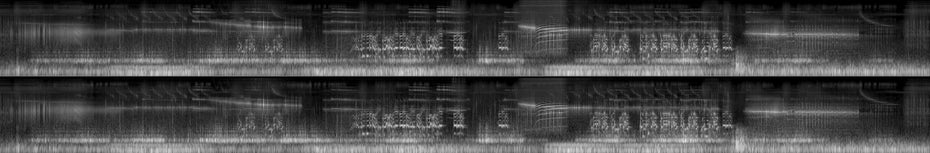

Auch vor der eigenen Website macht Aimee van Wynsberghe nicht halt. Der Font sei auf allen Geräten verfügbar, verschiedene Grautöne kämen zum Einsatz, sodass Nutzer:innen beim Surfen nicht die Cloud anzapfen müssen und so Rechenpower sparen, erklärt sie beim Videocall aus ihrem Büro Ende September. Van Wynsberghe ist zu diesem Zeitpunkt vollauf damit beschäftigt, die Eröffnung ihres „Sustainable AI Lab“ vorzubereiten. Und dazu gehört auch eine nachhaltig gestaltete Website. Parallel bereitet sie eine Kunstinstallation für die 26. UN-Klimakonferenz in Glasgow vor: Zusammen mit der Künstlerin Roosmarijn Pallandt will sie unter dem Titel „Light sounds Air“ ein Fotosynthese-Sonogram zeigen, das die Menschen an die Selbstheilungskräfte der Natur erinnern soll, die von uns, aber auch von der Technologie teilweise beeinträchtigt würden.

Die Kanadierin ist seit Februar 2021 Humboldt-Professorin für „Applied Ethics of Artificial Intelligence“ an der Universität Bonn und damit Trägerin des mit 3,5 Millionen Euro höchstdotierten deutschen Forschungspreises. Mit ihrer Arbeit wolle sie „Bonn zur globalen Drehscheibe für nachhaltige KI-Forschung machen und zeigen, dass künstliche Intelligenz den Menschen, dem Planeten und der Industrie zugutekommen kann, wenn sie richtig gemacht wird“, kündigte sie zu ihrem Antritt an.

„Ethik ist nicht länger etwas, was einem erst im Nachhinein einfällt“, sagt van Wynsberghe im Gespräch. Als sie 2008 an ihrer Doktorarbeit über Roboterethik geschrieben habe, sei das noch anders gewesen. „Roboter-was???“, erinnert sich die Wissenschaftlerin an die anfänglichen Reaktionen auf ihre Arbeit.

Heute sei es dagegen allgemein anerkannt, dass Ethiker:innen Teil von Entwicklungsteams sind. Als Mitglied der von der Europäischen Kommission eingesetzten Expert:innengruppe für künstliche Intelligenz sowie in ihrer Arbeit für Thinktanks, der G20, dem World Economic Forum und Beratungsunternehmen wie Deloitte habe sie den „wunderbaren Trend miterlebt, dass Ethik im Entwicklungsprozess als Ressource, als hilfreiches Tool anerkannt wird und nicht länger als etwas, das Innovation hemmt.“

t3n: Frau van Wynsberghe, auf Twitter lautet ihr Handle „Aimeevanrobot“; Sie haben sich lange Zeit auf Roboterethik spezialisiert. Warum beschäftigen Sie sich jetzt stattdessen mit nachhaltiger künstlicher Intelligenz?

Aimee van Wynsberghe: Lassen Sie mich dazu kurz erklären, warum ich mich überhaupt mit Robotik auseinandergesetzt habe. Während meines Studiums war ich Teil einer Arbeitsgruppe, die sich sehr intensiv mit Operationsrobotern beschäftigt hat: Wir haben sie getestet und Chirurg:innen trainiert, sie zu nutzen. Dabei haben wir viel Aufmerksamkeit darauf verwendet, wie Chirurg:innen mit der Technologie interagieren, und weniger auf das große Ganze geschaut: Wie sich Technologie auf eine gute Art und Weise umsetzen lässt. Von Robotern ausgehend, war es ein natürlicher Schritt, über die Software hinter der Maschine nachzudenken. Und das ist in einigen Fällen nun mal künstliche Intelligenz. Und dann ist KI auch geradezu explodiert – in einem Moment waren es nur ein paar wenige kommerzielle Anwendungen und dann war KI plötzlich überall. KI ist kein kurzlebiger Trend, sondern durch die Art und Weise, wie Algorithmen genutzt werden, ein gewaltiges soziales Experiment. Deshalb sind Ethiker:innen in der Techbranche so notwendig.

„Nachhaltige KI muss den ganzen Lebenszyklus umfassen.“

Sie betonen in Ihrer Arbeit, dass es wichtig sei, zwischen KI für die Nachhaltigkeit und der Nachhaltigkeit von KI zu unterscheiden. Warum?

Es gibt eine wachsende Bewegung, KI für „gute“ Zwecke einzusetzen – etwa AI4Good für das Erreichen der UN-Nachhaltigkeitsziele. Aber es ist an der Zeit, einen Schritt weiterzugehen und die Nachhaltigkeit der Entwicklung von KI und den Einsatz von KI-Systemen selbst anzugehen. Es gibt zum Beispiel eine sehr bekannte Studie, die aufzeigt, dass das Training eines einzigen Deep-Learning-Natural-Language-Processing-Modells so viel CO2-Emissionen produziert wie fünf Autos über ihre gesamte Lebensdauer. Andere Studien haben gezeigt, dass Googles Alpha Go im Laufe von 40 Trainingstagen so viel CO2 verursacht wie 1.000 Stunden Flugverkehr oder der CO2-Fußabdruck von 23 US-Haushalten. Nachhaltige KI muss den ganzen Lebenszyklus umfassen: die Nachhaltigkeit von Design, Training, Entwicklung, Validierung, Re-Tuning, Implementierung und Einsatz.

Inwiefern wird denn die Frage nachhaltiger KI bereits in der Klimapolitik berücksichtigt?

Es gibt da eine Diskrepanz: Auf der einen Seite spricht die Europäische Kommission von KI-Ethik und dem Schutz der Privatsphäre, von Fairness und Wohlergehen – und auf der anderen Seite beschäftigt sie sich mit dem Green Deal und Maßnahmen, um die Folgen des Klimawandels abzuschwächen sowie die CO2-Emissionen drastisch zu senken. Ich finde es bizarr, dass wir bisher nicht auch an die Umweltfolgen von KI denken und wie diese in KI-Regulierungen berücksichtigt werden.

Wie erklären Sie sich das?

Nachhaltigkeit ist in sich eine Frage der Ethik, eine Frage der Menschenrechte, da das Training von KI sich auf die Umwelt auswirkt: durch die CO2-Emissionen, die benötigte Rechenkraft, das Schürfen von Mineralien und auch Elektroschrott. Und wer trägt die Konsequenzen? Die Menschen im globalen Süden. Für uns ist es einfacher, sich auf die Privatsphäre zu konzentrieren und die Umweltfolgen zu ignorieren. Aber es ist unabdingbar, die Umweltfolgen jetzt anzugehen, wenn wir wirkliche inklusive und faire KI schaffen wollen.

Das Fotosynthese-Sonogram der Künstlerin Roosmarijn Pallandt ist Teil vom „Art-Engagement-Programm“ des Sustainable-AI-Labs von Aimee van Wynsberghe. Die Installation trägt den Titel „Light sounds Air“ und wurde bei der 26. UN-Klimakonferenz in Glasgow Anfang November 2021 ausgestellt.

Sie fordern, dass Unternehmen verpflichtet werden, Emissionen zu überwachen und offenzulegen.

Aktuell gibt es keine Regulierungen zu KI und ihren Umweltfolgen. Der AI Act der Europäischen Kommission etwa sieht dafür keine Regulierungsoptionen vor. Ich war im September auf einer Podiumsdiskussion und Google sagte dort, sie wollen 24/7 CO2-frei bis 2030 sein; aber es ist nicht genug, wenn es ein Unternehmen macht. Es gibt so viele kleine und mittlere Unternehmen, die ebenso CO2-Emissionen verursachen, und darüber müssen wir Bescheid wissen. In meiner Rolle als Humboldt-Professorin an der Universität Bonn will ich darauf aufmerksam machen, damit der AI Act auch die Berichtspflicht für Unternehmen und die Forschung beinhaltet. Die deutsche KI-Strategie legt auf diesen Punkt ein größeres Augenmerk. Deshalb freue ich mich, in Deutschland zu arbeiten, da hier die Folgen für die Umwelt ernst genommen werden.

Viele Unternehmen und Menschen empfinden allein die Aussicht auf Regulierungen als erdrückend. Irgendwann haben die Leute in der Regel auch genug von all den Weltuntergangsszenarien.

Ich kann nachvollziehen, dass es wie ein weiteres Hindernis wirken kann, und dass Techunternehmen denken könnten: erst die Datenschutzgrundverordnung – und jetzt das. Aber es geht nicht darum, Hürden aufzubauen, sondern Innovationen zu schaffen, ohne dabei den Planeten zu zerstören. Europa hat die Chance, KI nicht nur in einer ethischen und vertrauenswürdigen Art und Weise zu gestalten, sondern auch so nachhaltig wie möglich. Die Welt wird dann auf uns schauen: Woher kommen ihre Energiequellen? Wie hoch ist der Anteil an grünen Servern? Es geht also nicht darum, Innovation zu hemmen, sondern sinnvolle Innovation zu schaffen. Ich sehe meine Forschungsarbeit im Dienst der Gesellschaft und will Menschen erreichen, ohne sie abzuschrecken. Genauso möchte ich dabei mitwirken, die richtigen Instrumente zu finden – etwa groß angelegte CO2-Tracker.

Ist das aber nicht unfreiwillig ironisch, Technologie zu nutzen, um die negativen Auswirkungen von Technologie zu überwachen?

Ja, das klingt nach einem Teufelskreis. Aber was ich damit sagen will, ist, dass wir eine technologische und eine soziale Lösung brauchen. Wir müssen dafür ein Bewusstsein schaffen, unser Konsumverhalten ändern und auch die Herstellung von Produkten. Die CO2-Emissionen zu überwachen, ist der erste Schritt, um das Ausmaß zu erfassen. Dann geht es darum, Obergrenzen zu setzen – damit wir wissen, dass wir ein KI-Modell nicht länger als eine gewisse Anzahl von Stunden trainieren sollten, weil es sonst zu viel Energie kostet. Der nächste Schritt ist dann die Regulierung und Minimierung von Emissionen.

Indem Sie sagen, dass es eine soziale und technologische Lösung braucht, erkennen Sie aber auch an, dass der Einsatz von KI von Vorteil sein kann, um den Klimawandel abzuschwächen?

Auch wenn ich furchtbar negativ klinge, bin ich nicht gegen Technologie oder KI. Ich bin gegen technologischen Solutionismus, also die Vorstellung, dass wir bei einem Problem einfach sagen, die Technologie wird es richten – als ob es ein magisches Pflaster wäre, das man einfach drüber klebt. Ich bin für KI-Anwendungen mit konkretem Ziel: um Naturkatastrophen vorherzusagen oder den Energieverbrauch in Rechenzentren zu analysieren und zu reduzieren, wie Google es mit Deepmind tut. Aber ich bin gegen KI als Selbstzweck, vor allem in einem humanitären Kontext, wenn gefährdete Gesellschaftsgruppen betroffen sind, und auch gegen den Einsatz für die Erkennung von Emotionen.

Wenn es darum geht, soziales Verhalten zu ändern, landet man schnell beim sogenannten Nudging. Wie stehen Sie dazu, Big Data und KI einzusetzen, um die Menschen dazu zu bringen, sich besser, grüner zu verhalten?

Ich glaube nicht, dass es funktioniert, Menschen mithilfe von Empfehlungsalgorithmen zu verantwortungsbewusstem Verhalten zu bewegen. Stattdessen wollen wir doch, dass die Menschen wirklich verantwortungsbewusst werden, und nicht zu Zombies. Es geht darum, Menschen aufzuklären, damit sie verstehen, was hinter den Google-Suchanfragen steckt, hinter den Problemen des Klimawandels und was sie selbst tun können, indem sie gewisse Produkte kaufen. Ich glaube nicht, dass wir zwingend dafür Technologie brauchen. Das Ziel ist, Bewusstsein zu schaffen mit Bürgerversammlungen, Konferenzen – Menschen miteinander ins Gespräch zu bringen. Und immer dabei die Frage zu stellen: Ist Technologie, KI, der beste Weg, um unsere Ziele zu erreichen?

Und wenn wir Technologie außen vor lassen und Green Nudging dadurch praktizieren, dass wir klimafreundliche Produkte im Regal gut sichtbar und erreichbar platzieren?

Das ist etwas anderes als das Empfehlungssystem. Ein gutes Beispiel ist Google Maps, das anzeigt, welche Route die mit dem geringsten CO2-Ausstoß ist. Damit gibt man Menschen Handlungsoptionen und eine Wahl. Aber dann bleibt noch die Frage: Kann ich es mir leisten, diese Wahl zu treffen?