Smartglasses von Ray-Ban und Meta ausprobiert: So hilfreich ist ein KI-Assistent im Alltag

KI-Gadgets wie der Humane AI Pin oder der Rabbit R1 sind eines der meist besprochenen Tech-Themen der vergangenen Wochen. Unter anderem, weil die Reviews alles andere als gut ausfallen. Die Software der Geräte ist unausgereift und der Nutzen im Alltag fraglich. Auch der Formfaktor, zum Beispiel eine Brosche, wird kritisiert.

Neben den beiden genannten Geräten gibt es allerdings noch einen dritten Hersteller, der ein KI-Gadget mit ganz ähnlichen Funktionen anbietet und etwas unter dem Radar läuft. Nämlich Meta mit seinen Ray-Ban-Smartglasses.

Im Herbst haben wir uns die smarte Brille schon einmal genauer angesehen, damals war sie allerdings ein Gerät, das hauptsächlich für Social-Media-Postings und Instagram-Lives geeignet war. Doch dank eines Beta-Programms ist die Meta AI inzwischen auf der Brille verfügbar. Höchste Zeit also, einen zweiten Blick zu wagen.

Vom Social-Media- zum KI-Gadget

Die Smartglasses führen zwei Leben. Da wäre zum einen der Funktionsumfang, mit dem die Brille vorgestellt wurde, und zum anderen die KI-Funktionen, die später hinzukamen.

Ohne die KI eignen sich die Glasses zum Beispiel für Fotos oder kurze Videoclips (maximal 60 Sekunden). Diese sind nach der Aufnahme in der Meta-View-App auf dem Smartphone zu finden und können dann direkt zum Beispiel bei Instagram oder Facebook gepostet werden. Wahlweise kann man die Glasses in Insta-Live-Videos auch als Streaming-Kamera benutzen.

Die Kamera kann mit ihren zwölf Megapixeln Fotos mit 3.024 mal 4.032 Pixeln oder 1080p-Videos mit 30 FPS aufnehmen, allerdings nur im Hochformat. An Bord sind 32 Gigabyte interner Speicher, der für rund 500 Fotos oder knapp 100 Videos reichen soll.

Wer möchte, hört über die zwei integrierten Lautsprecher außerdem Musik oder Podcasts – wobei letztere eher zu empfehlen sind, da die Qualität der Lautsprecher im mittleren Bereich angesiedelt ist. Oder man nutzt die Brille dank der fünf integrierten Mikrofone als Freisprecheinrichtung für das Smartphone.

Bei der Laufzeit kommt die Brille auf ungefähr drei Stunden durchgehende Musikwiedergabe bei mittlerer Lautstärke, danach muss sie für eine Ladepause in das mitgelieferte Ladeetui, welches laut Meta noch einmal für insgesamt 32 Stunden Laufzeit reichen soll.

Hey Meta, schau mal

Einen deutlich größeren Funktionsumfang liefern die Glasses aber mit der bereits angesprochenen KI-Anbindung. Auch wenn diese in Deutschland offiziell noch nicht verfügbar ist, ist es uns vor einigen Tagen gelungen, sie dennoch in der App zu aktivieren.

Nach ein bisschen Recherche im Netz und bei Reddit kommt es wohl immer wieder vor, dass die Brille auch außerhalb der USA die Funktion freigibt, allerdings scheint es sich dabei eher um Zufall oder Glück zu handeln, ob man betroffen ist oder nicht. Und natürlich spricht die KI bisher nur Englisch. Sie kann einzelne Begriffe zwar ins Deutsche übersetzen, aber Sprachbefehle nimmt sie bisher nur in ihrer Muttersprache entgegen.

Nach der Aktivierung greift eine multimodale KI von Meta auf Wunsch der Nutzer:innen auf die Kamera, die Lautsprecher und die Mikrofone in den Smartglasses zu. Das heißt, die KI kann auf die Aktivierungsphrase „Hey Meta“ hin auf Sprachbefehle reagieren, Fragen beantworten und auf Wunsch auch Fotos schießen und diese dann analysieren. Dies geschieht durch den Befehl: „Hey Meta look and …“

Die KI-Funktionen

Aber was kann Meta AI denn jetzt genau? Und wie sinnvoll ist sie im Alltag einsetzbar? Nach mehreren Tagen lässt sich festhalten: Die Brille wird jetzt viel häufiger eingesetzt als vor dem KI-Update. Ein bisschen Fotos und Videos für die Socials zu schießen ist eine nette Funktion, die aber auch durch ein Smartphone sehr gut erledigt werden kann.

In einer Brille einen KI-Assistenten permanent mit sich herumzutragen, der jederzeit Fragen beantworten kann, ist hingegen sehr viel spannender. In der Küche kann die KI zum Beispiel Rezepte für einen heraussuchen oder den Unterschied zwischen Parmesan und Pecorino erklären. Das klappt teilweise nach einer kurzen Gedenkpause, manchmal kommen die Antworten aber sogar fast direkt. In solchen Momenten fühlt sich die Nutzung sehr intuitiv und nahtlos an.

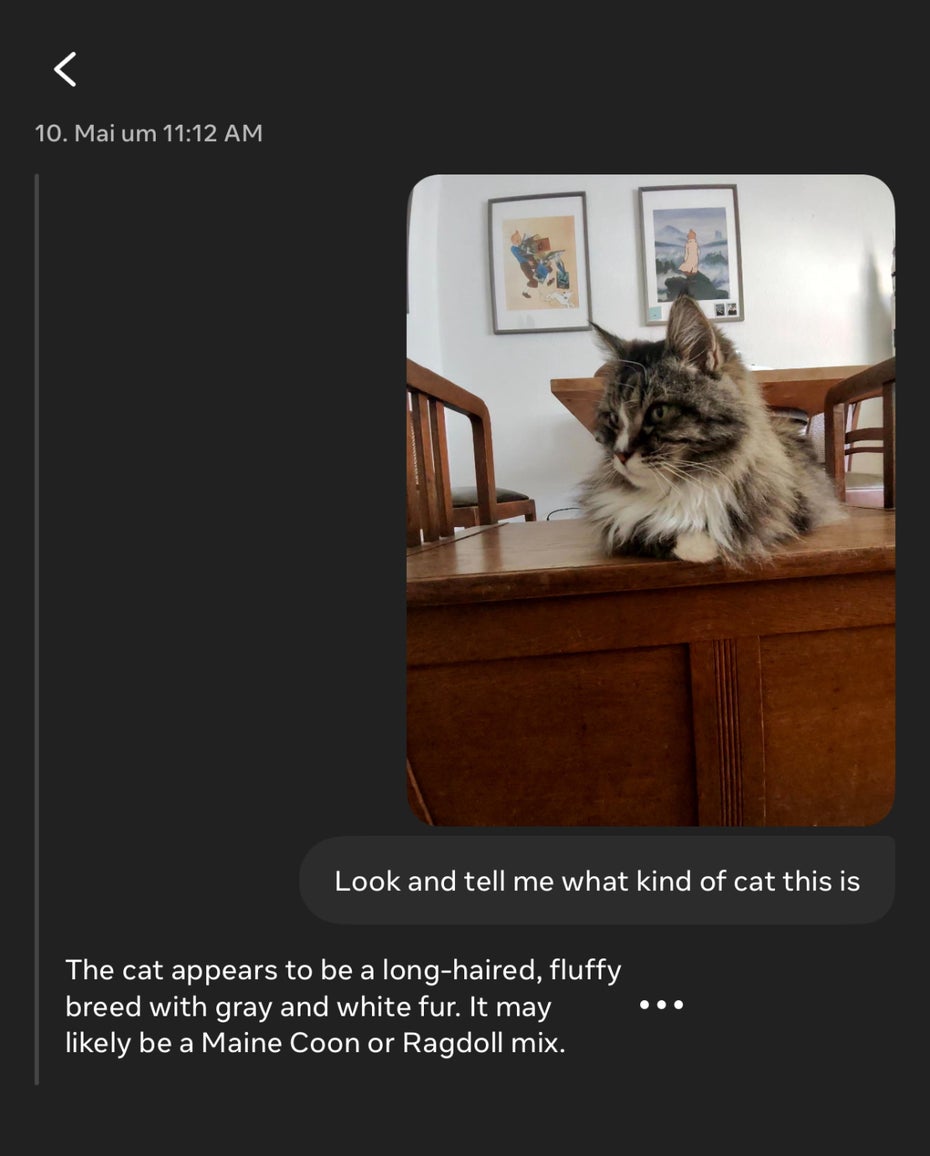

Bei der Bilderkennung liegt die Meta AI oft richtig – auch wenn in diesem Beispiel keine Maine Coon, sondern eine sibirische Katze auf dem Foto zu sehen ist. (Foto: Screenshot Meta View App)

Und auch die Bilderkennung bietet nützliche Funktionen. Welche Pflanze wächst da eigentlich? Die Meta KI weiß es. Und was steht da auf diesem Schild in einer fremden Sprache? Der Assistent macht ein Foto und übersetzt den Text für einen.

Nutzen wir die Smartglasses nur für die KI-Funktionen und verzichten auf Musik oder Livestreams bei Instagram, dann reicht der Akku in unserem Test tatsächlich auch fast einen Tag lang. Im Stand-by-Modus scheinen die Glasses relativ wenig Strom zu verbrauchen.

KI bleibt KI

Klar wird im Test aber auch: Wir haben es hier mit einer generativen KI zu tun, die all die Probleme hat, die andere KI auch haben. Bei zu aktuellen Wissensfragen oder Nachrichten sollte man also aufpassen. Die Frage, wer das letzte Formel-1-Rennen gewonnen hat, beantwortet die KI nicht etwas mit Lando Norris, sondern mit Lewis Hamilton. So erfolgreich dieser auch als Fahrer ist, sein letzter Sieg ist inzwischen fast zwei Jahre her.

Und auch andere Halluzinationen sind immer mal wieder ein Thema und betreffen auch die Bilderkennung. Auf die Frage, was die KI auf einem Foto erkennt, werden manchmal auch Dinge erwähnt, die nicht vorhanden sind. Zwischendrin verweigert die Meta AI auch mal den Dienst, bricht eine Anfrage ab oder gibt schlicht keine Antwort. Nicht selten ist dann die Internetverbindung zu schwach oder die Bluetooth-Verbindung zum Smartphone abgerissen.

Ebenfalls vermissen wir die Anbindung an Funktionen wie das Stellen eines Timers oder das Zugreifen auf Termine, um diese verwalten zu können. Und auch das Verfassen oder Beantworten von Nachrichten wäre etwas, bei dem ein KI-Assistent gut unterstützen könnte – allerdings auch nur, wenn man das Thema Datenschutz und Datensparsamkeit außen vor lässt.

Ein Blick in die Zukunft

Trotz dieser Einschränkungen zeigen die Ray-Ban-Smartglasses schon jetzt, was in sehr naher Zukunft mit KI-Assistenten möglich sein wird und wie sehr es dabei auf den Formfaktor ankommt. Der Humane AI Pin ist eine schwere Brosche, der Rabbit R1 ein Plastikgehäuse mit einem Bildschirm. Die Smartglasses sind hingegen kaum von einem normalen Brillengestell zu unterscheiden und wer sowieso eine Brille trägt, für den ändert sich bei der Nutzung wenig bis gar nichts. Die KI ist nur einen Sprachbefehl entfernt und wartet auf ihren Einsatz.

Nur für die KI-Funktionen sollte man die Ray-Ban-Meta-Glasses für 329 Euro allerdings noch nicht kaufen, denn diese sind aus den bereits beschriebenen Gründen noch nicht komplett ausgereift. Wenn einem die Grundfunktionen mit Kamera und Lautsprechern reichen, ist das natürlich etwas anderes.

In den kommenden Monaten wird sich beim Thema KI in den Meta-Glasses aber sicher noch viel ändern und früher oder später wird die Meta AI auch offiziell in Deutschland verfügbar sein. Spätestens dann werden wir die Brille noch einmal genauer testen. Bis dahin bleiben die Glasses ein spannender Blick in die nahe Zukunft.