Google AI: Generative KI von Gemini wird Teil von Android

Im Zuge der Google I/O 2024 hat das Unternehmen neue Möglichkeiten angekündigt, wie Nutzer:innen bald mit Android-Smartphones interagieren können. Neben der Gemini-App wird die „Circle-to-Search“-Funktion massiv ausgebaut und „Google AI“ zu einem zentralen Bestandteil von Android.

„Google AI“ wird das Herzstück von Android

KI ist für Google im Grunde ein alter Hut. Bereits 2016 bezeichnete Google-CEO Sundar Puchai das Unternehmen als „AI-Company“. Auch in den Pixel-Smartphones des Unternehmens sowie von Partnern wie Samsung finden sich schon zahlreiche KI-Funktionen. Mit der Ankündigung von „Google AI“ will das Unternehmen die KI-Stärken des Betriebssystems in den Vordergrund rücken und weiter ausbauen.

Laut Google werden „Circle to Search“ und das KI-Modell Gemini sowohl lokal auf dem Gerät als auch in der Cloud eine größere Rolle spielen. Folgende Funktionen sollen in den kommenden Monaten Teil von Android werden.

„Circle to Search“ als „Hausaufgabenhilfe“

Als eine der großen Neuerungen hebt Google zunächst das Update für das mit dem Galaxy S24 (Test) eingeführte „Circle to Search“ hervor: Mit dieser Funktion kann man Inhalte in einer App ohne Umwege mit einer Geste suchen. Dabei muss die jeweilige App nicht verlassen werden, stattdessen wird die Suche durch ein Overlay realisiert.

Bisher war es beispielsweise möglich, Produkte zu suchen und Texte über den gesamten Bildschirm zu übersetzen. Laut Google ist die Funktion auf über 100 Millionen Smartphones verfügbar – die meisten davon sind aber nicht von Google, sondern von Samsung.

Besitzer:innen eines der kompatiblen Smartphones oder Tablets können die „Circle-to-Search“-Funktion laut Google ab sofort auch als Hausaufgabenhilfe verwenden. Die Funktion soll Google zufolge in erster Linie für Teile von Aufgaben dienen, bei denen Schüler:innen „nicht weiterkommen“.

Um eine Aufgabe in Physik oder Mathematik zu lösen, müssen sie den Aufgabenteil nur einkreisen und erhalten „eine detaillierte Anleitung zur Lösung“, ohne ihr digitales Aufgabenblatt oder ihre Lern-App verlassen zu müssen.

Dieser Hausaufgabenhelfer bleibt laut Google nicht allein: Im Laufe des Jahres soll „Circle to Search“ auch komplexere Aufgaben lösen können, „in denen unter anderem symbolische Formeln, Grafiken und Diagramme vorkommen“. Realisiert werden soll das laut Google durch „LearnLM“. Dabei handelt es sich um neue Lernmodelle, die speziell für das Lernen entwickelt wurden.

Gemini-App erhält Overlay und erfasst Kontext

Auch Googles generatives KI-Modell Gemini soll neue Funktionen erhalten. Die Gemini-App für Android, die laut Google bald auch in Deutschland erscheint, wird Teil des Betriebssystems und soll immer besser den Kontext dessen erfassen, was auf dem Smartphone-Bildschirm zu sehen ist und welche App gerade genutzt wird.

Laut Google wird es bald möglich sein, ein Overlay der Gemini-KI über die aktiv genutzten Apps zu legen. Dadurch könne Gemini „noch einfacher und vielfältiger genutzt werden“, so der Hersteller.

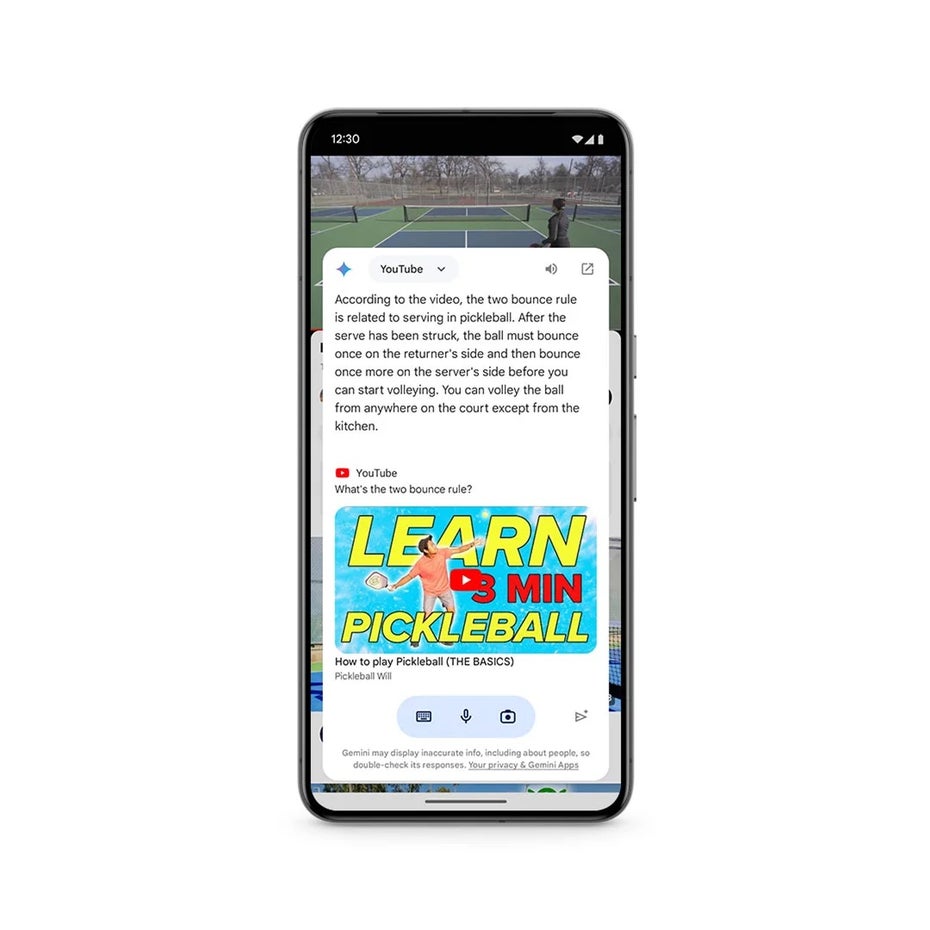

Gemini kann für euch künftig Youtube-Videos zusammenfassen. (Bild: Google)

So könne man beispielsweise KI-generierte Bilder einfach in Gmail, Google Messages und andere Apps einfügen. Ebenso sei es möglich, Youtube-Videos zusammenfassen zu lassen. Mit der kostenpflichtigen Version Gemini Advanced können künftig auch PDFs zusammengefasst werden, um Informationen schneller zu erfassen. Diese Funktionen sollen laut Google „in den nächsten Monaten auf mehreren hundert Millionen Geräten“ landen.

Außerdem will Google Gemini weiter verbessern, um dynamischere Vorschläge für Bildschirminhalte zu machen.

Gemini Nano wird multimodal

Während einige Gemini-Modelle in der Cloud berechnet werden, kann das kleinste Modell, Gemini Nano, vollständig auf dem Smartphone ausgeführt werden. Bisher hatte es eher eingeschränkte Funktionen wie die Transkription von Sprachaufnahmen der Rekorder-App.

Mit Gemini Nano soll Android nun das erste mobile Betriebssystem werden, das ein integriertes Foundation-Model bietet, das vollständig auf dem Gerät ausgeführt wird, sodass alle verarbeiteten Daten privat bleiben, so Google.

Die neueste Version von Gemini Nano soll im Laufe dieses Jahres zunächst auf den Pixel-Smartphones umfassende multimodale Funktionen bieten. Das bedeutet, dass das Smartphone neben der Verarbeitung von Text auch kontextbezogene Informationen wie Bilder, Ton und gesprochene Sprache verarbeiten kann.

Gemini Nano soll auch in Talkback integriert werden, um Menschen mit Sehbehinderungen oder eingeschränktem Sehvermögen bessere und präzisere Beschreibungen von Bildinhalten zu liefern. Laut Google stoßen Talkback-Nutzer:innen im Schnitt auf 90 nicht gekennzeichnete Bilder pro Tag. Mithilfe der lokalen KI sollen die fehlenden Informationen ergänzt werden.

Warnmeldungen bei Betrugsverdacht während eines Anrufs

Gemini Nano soll auch vor möglichem Telefonbetrug schützen: Google testet derzeit eine neue Funktion, bei der die lokale KI während eines Anrufs Gesprächsmuster analysiert, die auf Betrug hindeuten.

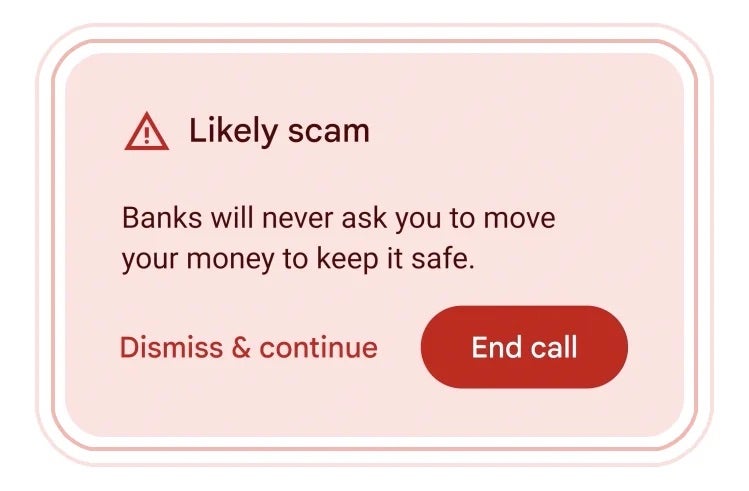

Android erhält eine Scam-Erkennung, die lokal auf dem Gerät ausgeführt wird. (Bild: Google)

Das Android-Gerät würde zum Beispiel eine Warnung ausgeben, wenn ein vermeintlicher Bankmitarbeiter dazu auffordert, dringend Geld zu überweisen, mit einer Geschenkkarte zu bezahlen oder Informationen wie PIN oder Passwort preiszugeben. „Echte“ Bankmitarbeiter:innen würden das nie machen.

Google wird im Laufe des Jahres weitere Details zu dieser Funktion veröffentlichen. Klar ist jetzt schon, dass sie von den Nutzer:innen aktiviert werden muss.

Googles Gemini wird omnipräsent

Im Zuge der I/O hat Google deutlich gemacht, dass das KI-Modell nicht nur Teil von Android wird, sondern in nahezu jedem Produkt des Unternehmens landen wird. Sowohl in der Suche, als auch in Workspace, Notebook LLM und vielen weiteren.

Auch der neue KI-Assistent, der unter dem Codenamen Project Astra entwickelt wird, basiert auf Gemini. Das Tool kann als eine Art neuer, multimodaler Google Assistant betrachtet werden und ist ein Weg, wie mit Gemini künftig interagiert werden kann. Der Assistent soll dazu in der Lage sein, in Echtzeit die Welt zu sehen, zu wissen, wo sich Dinge (zum Beispiele eine Brille) befinden und wo man sie liegen gelassen hat. Auch kann der Assistant Google zufolge Fragen beantworten oder bei fast allen Aufgaben helfen, so die Idee.

Eine erste Version von Astra soll schon im Laufe dieses Jahres Teil der Gemini-App werden, heißt es. Unklar ist derweil, ob das KI-Tool dann auch schon außerhalb der USA angeboten wird.

Die KI-Funktionen sind übrigens überwiegend unabhängig von der Android-Version, jedoch dürften wohl nicht alle Geräte in den Genuss von Gemini Nano kommen. Neues zu Android 15 will Google erst am zweiten Tag der Google I/O, also am 15. Mai verraten. Im Zuge dessen wird die zweite Beta veröffentlichen und es wird einen Ausblick auf Wear OS 5 geben.