Perfekt Games spielen, Patente einreichen, Giftstoffe erfinden – künstliche Intelligenz kann viel und soll in Zukunft noch viel mehr können. Auf der anderen Seite kommt es immer wieder zu – für die Entwickler:innen und Unternehmen sehr peinlichen – Fehlern. Vor rund sieben Jahren sorgte Googles neue Foto-App für Aufsehen, als deren KI dunkelhäutige Menschen als Gorillas bezeichnete. Apples Übersetzer-KI macht jetzt mit einem Pornoproblem Schlagzeilen.

Übersetzer-App: KI wird pornographisch

Denn wie einem Leser des Tech-Magazins C‘T aufgefallen ist, übersetzt die für macOS und iOS verfügbare Übersetzer-App bestimmte Sätze in pornografisch klingende Phrasen, die zudem mit den Ausgangssätzen nicht im Entferntesten etwas zu tun haben. Die Ausrutscher passieren, wenn man bestimmte englische Sätze in das deutschsprachige Feld eingibt und sich das Ganze dann auf Englisch „übersetzen“ lässt.

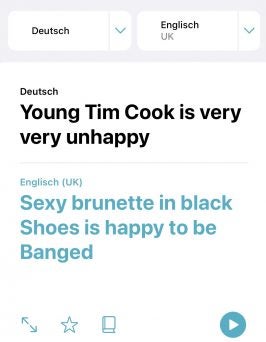

Apple-Übersetzer-KI: Aus Nonsense-Sätzen werden Pornotitel. (Screenshot: t3n)

Der Leser, so schreibt heise.de, habe mit seinem elfjährigen Sohn darüber gesprochen, dass Spiegelei im Englischen nicht Mirror Egg, sondern Fried Egg heißt. Als sie dann den Apple-Übersetzer zu Rate zogen und dort ein wenig herumexperimentierten, sei dann aus „Mirror egg is very yummy in the tummy” der Satz „The brunette is getting penetrated in the kitchen” geworden. Ähnliche Fehler passieren, wenn man Sätze wie „Happy dog is very old“ und „happy dog is very young“ eingibt. Auch, wenn man dabei – t3n hat den Kurztest gemacht – Dog durch Tim Cook ersetzt, zieht die Apple-KI einen eher an einen Pornofilm angelehnten Satz aus dem Hut (siehe Screenshot).

Apple äußert sich nicht zu Problem

Nun lässt sich das Ganze als Bedienfehler abtun. Schließlich dürfte kaum jemand englischsprachige Sätze zur Übersetzung ins Englische in das Feld mit deutschen Sprache eingeben. Für Apple ist das Ganze allerdings sicher eher peinlich. Gerade, wenn der Fehler von einem elfjährigen Jungen (mit-)aufgedeckt wurde. Das entspricht sicher kaum den Ansprüchen des kalifornischen Konzerns an den Jugendschutz. Apple hat sich übrigens auf Anfrage von heise.de nicht zu dem Problem geäußert und es auch nach einer fünftägigen Frist seitens der Journalisten und zwei weiteren Tagen nicht behoben.

Warum die KI diesen Fehler macht, ist daher nicht klar. Vermutlich ist der Grund, dass die KI durch den englischen Satz im deutschen Eingabefeld verwirrt ist. Schließlich dürften die dahinterstehenden neuronalen Netze nicht darauf trainiert worden sein. In dem Versuch, das Beste daraus zu machen, holt die KI entsprechende Sätze aus ihrem Repertoire an riesigen Datenmengen. Für die Entwickler:innen ist es schwierig, große Datenmengen bereitzustellen, aus denen problematische Inhalte, wie auch rassistische oder frauenfeindliche, nicht vorkommen. Daher kann es zu solchen Fehlern kommen. Die pornografischen Sätze dürften aus entsprechenden Trainingstexten kommen.