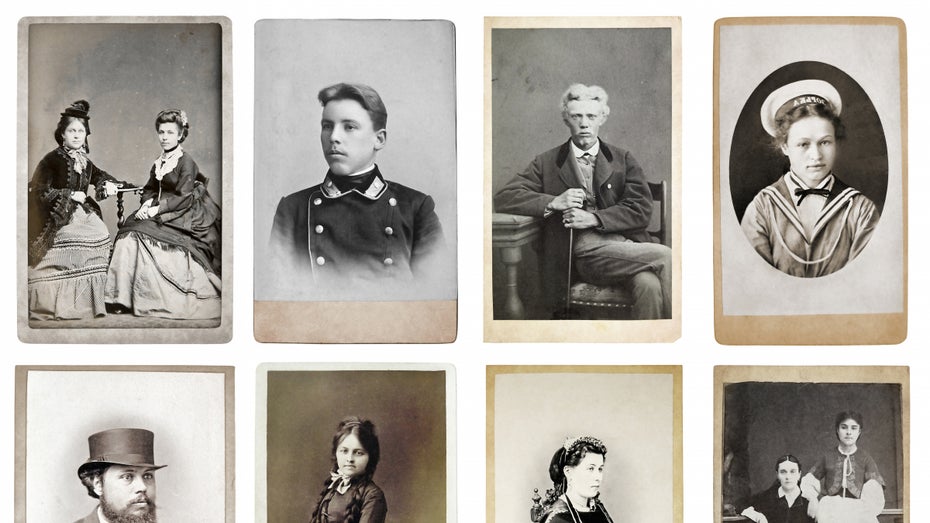

Ob Alexander der Große oder die verstorbene Großmutter – sie alle wurden im vergangenen Jahr durch „Deep Nostalgia“ für ein paar Sekunden aus ihrer starren Porträtposition geholt. Kopf drehen, auf und ab schauen, freundlich lächeln, all das konnten die auf Gemälden, vergilbten Fotos oder Büsten festgehaltenen Gesichter dank künstlicher Intelligenz plötzlich.

Die Genealogieplattform Myheritage war einst in der Online-Community dadurch bekannt geworden, dass sie Menschen per DNA-Analyse aufzeigt, wo auf dem Planeten man überall Vorfahren finden könne. Dazu gibt es jeweils auch das ein oder andere Archivbild von unbekannten Ahnen mitsamt deren Geschichte.

2021 hat das Unternehmen aus Israel dann zusammen mit D-ID, einem Startup aus Tel Aviv, die Animation von alten Fotos ermöglicht. „Deep Nostalgia“ fand Anklang im Netz – nun gehen die Macher:innen noch einen Schritt weiter.

Statt sich nur zu bewegen, können die Menschen auf den Bildern jetzt Sätze sagen, die man ihnen in den Mund legt. Die Stimme dazu ist computergeneriert, die Lippenbewegungen der Animation werden auf den Text abgestimmt. Der Name der Funktion: „Livestory“.

Künstliche Intelligenz bringt Bilder zum Sprechen: So kannst du „Livestory“ nutzen

Sprechende Gemälde – gab es das nicht auch bei Harry Potter? Tatsächlich wurde die von D-ID entwickelte Deep-Learning-Technologie, die für „Livestory“ zum Einsatz kommt, unter anderem auch schon von Warner Bros in einer Harry-Potter-Ausstellung genutzt. D-ID stellt seine Technologien dabei über die API zur Verfügung und arbeitet über Nutzungslizenzen mit verschiedensten Unternehmen zusammen. Ein Patentierungsverfahren auf die Technologie hinter den sprechenden Porträts läuft.

Wer die Sprachanimation bei Myheritage testen möchte, braucht dafür zunächst einen Account auf der Plattform. Der lässt sich im Desktop oder im mobilen Browser sowie in der Myheritage-App kostenfrei anlegen. Die Anzahl der möglichen Animationen ist im Test-Angebot allerdings stark limitiert und wird erst im Bezahlmodus unbegrenzt. Nach dem Upload wird das Porträt animiert, der eingegebene Erzähltext wird durch einen künstlichen Stimmgenerator erzeugt.

Dabei ist die Umsetzung noch nicht perfekt, gibt Gil Perry, CEO und Mitgründer von D-ID, gegenüber Techcrunch zu – es handele sich eher um „sehr gute Lippensynchronisation“. Eben die sollte laut D-ID eigentlich für alle erdenklichen Sprachen funktionieren, bei Myheritage ist das Sprachrepertoire allerdings auf 31 Sprachen beschränkt. Neben verschiedenen Dialekten lässt sich auch das Geschlecht der sprechenden Person auswählen. Und wer auf die Computer-Stimme verzichten will, kann sogar seine eigene Audiospur hochladen.

Ist die „Livestory“ fertig, lässt sie sich beispielsweise auf Social Media teilen. So waren im vergangenen Jahr schon die sich bewegenden Gemälde von „Deep Nostalgia“ auf Tiktok viral gegangen.

Sprechende Gemälde per Deep Learning: „Unsere Kinder werden sich mit Albert Einstein unterhalten wollen“

Langfristig sieht sich D-ID mit seiner Technologie im Metaverse-Kontext, die Animation soll dann nicht mehr nur auf das Gesicht beschränkt, sondern für den ganzen Körper anwendbar sein. So könnte es irgendwann möglich sein, „Gespräche“ mit Verstorbenen im virtuellen Raum zu führen.

„Unsere Kinder werden sich mit Albert Einstein unterhalten wollen, um zu lernen, ihm zuzuhören und ihm Fragen zu stellen“, so Perry. Bis der Begründer der Relativitätstheorie dann aber wirklich perfekt antworten kann, gibt es auf technologischem Level noch einiges zu tun.