Imagebind: Metas OpenSource-KI soll realistische Umgebung generieren

Meta hat das KI-Tool Imagebind auf Github öffentlich zugänglich und es damit zu einem OpenSource-KI-Tool gemacht. Es soll Informationen ähnlich wie Menschen verknüpfen und neben Bildern auch Geräusche, Dreidimensionalität und Temperaturdaten zu einer Szene verknüpfen. Während das Ziel VR und das Metaverse sind, könnte es der Barrierefreiheit dienen.

Was ist Imagebind?

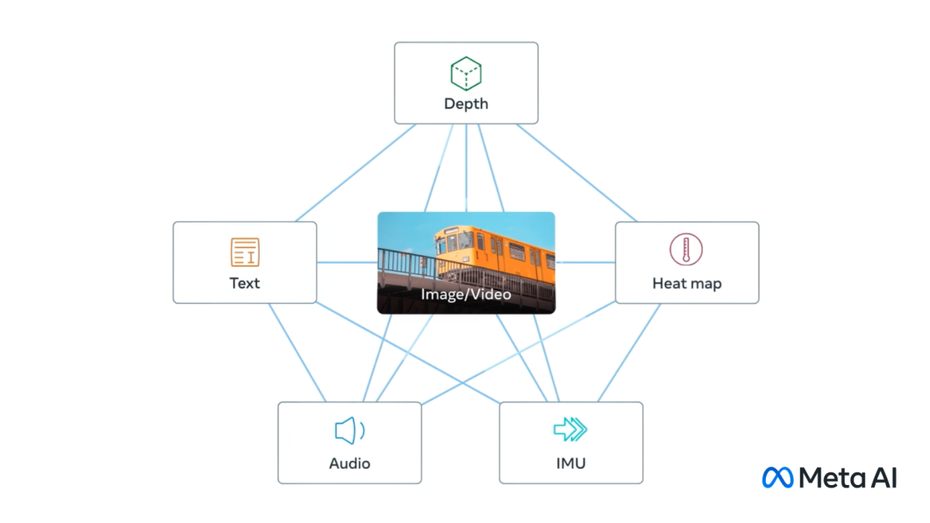

Mit Imagebind hat Meta ein Tool öffentlich zugänglich gemacht, das Datenpunkte so miteinander verknüpft, wie Menschen die Welt wahrnehmen oder sich eine Umgebung vorstellen. Während Tools wie Dall-E oder Stable Diffusion Text in Bild umwandeln, soll Imagebind dabei deutlich mehr Ebenen ausgeben können: Es soll Text, Bild, Video, Audio, Tiefe und damit Dreidimensionalität, Temperaturdaten und Bewegungsdaten miteinander verbinden können. Vor allem soll das geschehen können, ohne, dass alle Möglichkeiten einzeln trainiert werden müssen.

Imagebind ist dabei in einem frühen Stadium und soll langfristig in der Lage sein, komplexe Umgebungen aus Input wie Text, Bild oder Audioaufnahmen oder einer Kombination aus diesen drei Möglichkeiten zu generieren.

Bisher gibt es sechs Modalitäten: Tiefe, Text, Audio, Infrarotstrahlung und damit Wärmebilder und Bewegung beziehungsweise Position. Allerdings, so Ishan Misra, Rohit Girdhar und Alaaeldin El-Nouby im Meta-Blogbeitrag, könnten mehr Modalitäten „reichhaltigere, menschenzentrierte KI-Modelle ermöglichen“. Sie haben dabei Berührung, Sprache, Geruch und fMRI-Signale des Gehirns im Blick.

Was soll daran menschlich sein?

Steht ein Mensch an einer Kreuzung, nimmt das Hirn ganz automatisch alle Eindrücke auf: das Wetter, Bewegungen von Menschen, Autos, Vögeln, den Wind, die Häuser, die Ampeln, Fußgängerüberwege, Pfützen, das Café an der Ecke und wie gut besucht es ist.

Gleichzeitig wird, je nach Bedürfnis in der Situation bewertet, was gerade relevant ist – und daraus werden Informationen abgeleitet. Aus den Geschwindigkeiten der Autos wird geschätzt, ob sie am Zebrastreifen halten werden. Je mehr Leute im Café sitzen, umso höher ist die Wahrscheinlichkeit, keinen Platz zu finden oder dass es längere Wartezeiten gibt. Je bewusster eine Umgebung wahrgenommen wird, umso besser können Gefahren vermieden werden und Menschen sich den Gegebenheiten anpassen – ein evolutionärer Vorteil.

Computer wiederum ahmen immer mehr die multisensorische Verbindungen von Tieren nach – diese können sie andersherum nutzen, um Szenerien darzustellen, die auf begrenztem Input basieren. Während ein Prompt wie „ein Basset im Gandalf-Outfit, der auf einem Strandball balanciert“ bei Midjourney und Co zu einem bizarren Bild führen kann, könnte Imagebind ein Video generieren – inklusive Geräuschen, der Umgebung (ein Wohnzimmer oder ein Strand), die Temperatur und die präzisen Positionen vom Hund und anderen Lebewesen in der Szene.

VR, Metaverse, Content Creation, Gaming – und Barrierefreiheit?

Wie die Entwickler:innen im Meta-Blog schrieb: Aus einem Bild und einem Geräusch könnten so einfach Animationen entwickelt werden. Das passt zu Metas Ambitionen im Bereich VR, Mixed Reality und dem Metaverse. Ein VR-Headset beispielsweise könnte irgendwann komplett realistische 3D-Szenerien mit Geräuschen und Bewegungen erstellen.

Weitere Einsatzmöglichkeiten wären beispielsweise das Spieldesign: Spiele-Entwickler:innen könnten sich damit viel Beinarbeit im Game Design sparen. Content Creator:innen wiederum könnten immersive Szenen mit realistischen Geräuschkulissen schaffen. Mehr als nur für Influencer:innen könnte das verschiedensten Produkten dienen – denken wir nur an Meditationsapps, Coaching-Situationen, Werbung und mehr.

Multimedia-Beschreibungen in Echtzeit durch Imagebind könnten zudem Menschen mit Seh- oder Höreinschränkungen dabei helfen, die direkte Umwelt umfassender wahrzunehmen.