Gekritzel statt Sprachbefehl: KI-Forscher wollen Roboter mit Hilfe von Skizzen steuern

Skizzen steuern Roboter: Ikea-Anleitung als Inspiration für RT-Sketch. (Bild: Midjourney/ t3n)

Die jüngsten Fortschritte bei Sprachmodellen und Bild-KI-Systemen haben die Entwicklung von Robotern ermöglicht, die sich mit Sprach- beziehungsweise Textbefehlen oder über Bildvorgaben steuern lassen. Diese Art der Steuerung hat aber ihre Grenzen.

Skizzen statt Textbefehle oder Bildanweisungen

So können mehrdeutige Textbefehle die Roboter verwirren, ebenso wie realistische Bilder mit einer zu großen Anzahl von – für die Aufgabe nicht notwendigen – Details. Manchmal sind zudem keine Bilder vorhanden, auf denen die gewünschte Handlungsaufforderung zu sehen ist.

Abhilfe soll da jetzt ein von Forscher:innen der Stanford University und Google Deepmind entwickeltes System schaffen. Wie der Name schon andeutet, setzt RT-Sketch auf Skizzen, um Roboter bestimmte Aufgaben umsetzen zu lassen.

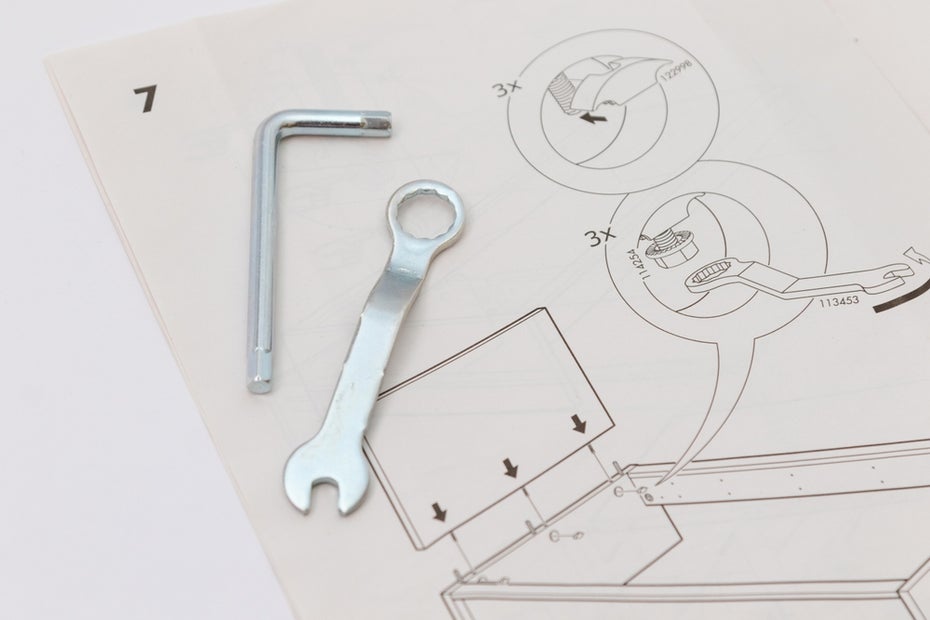

Technologie von Ikea-Bauanleitungen inspiriert

Die Idee der Steuerung per Skizze kam den Forscher:innen, als sie überlegten, wie sie Roboter dazu bringen könnten, Ikea-Bauanleitungen zu interpretieren und entsprechend umzusetzen.

Skizzen steuern Roboter: Ikea-Anleitung als Inspiration für RT-Sketch. (Foto: Lidero/Shutterstock)

„Bei solchen räumlich präzisen Aufgaben ist die Sprache oft sehr unklar, und ein Bild der gewünschten Szene ist nicht im Vorhinein verfügbar“, erklärt Studienautorin Priya Sundaresan von der Stanford University gegenüber Venturebeat.

Skizzen, so das Forschungsteam, sind dagegen einfach, leicht zu sammeln und reich an Informationen. Sie liefern etwa räumliche Informationen und spezifische Details, die in sprachlichen oder Bildanweisungen nur schwer zu vermitteln wären. Gleichzeitig fällt es Robotersystemen dadurch leichter, zu erkennen, welche Objekte für eine Aufgabe relevant sind.

RT-Sketch basiert auf Deepmind-Modell

RT-Sketch basiert auf dem Deepmind-Modell Robotics Transformer 1, das normalerweise Sprachanweisungen in Befehle für Roboter umwandelt. Das geänderte System ersetzt jetzt Eingaben in natürlicher Sprache durch visuelle Zielvorgaben wie Skizzen und Bilder.

Das Modell wurde mit 80.000 Aufnahmen von VR-gesteuerten Handlungen gefüttert, die etwa das Bewegen von Objekten oder das Öffnen und Schließen von Schubladen beinhalteten. Zu Trainingszwecken erstellten die Forscher:innen dann Skizzen aus einigen hundert Videos – und trainierten eine KI darauf, aus diesen Bildern Skizzen zu fertigen.

KI zeichnet Skizzen aus Videobildern

So trainiert, kann RT-Sketch ein bestimmtes Bild aus einem Video nehmen und daraus eine Skizze als Anweisung für den Roboter zeichnen, wie etwa bestimmte Objekte angeordnet werden sollen. Die Skizzenanweisung wird anschließend in einen spezifischen Roboterbefehl umgewandelt.

Den Forscher:innen zufolge kann RT-Sketch mit Systemen, die auf Sprachbefehle, Texteingaben oder Bildanweisungen basieren, mithalten. In vielen Szenarien kann die Anweisung per Skizze sogar erfolgversprechender sein. Jetzt soll das Modell um Anweisungen per Pfeile oder gekritzeltem Text erweitert werden.