My Face My Choice: Forscher:innen entwickeln KI-Modell für mehr Privatsphäre auf Social Media

Foto für Social Media? Mit MFMC sehen Fremde nicht dein Gesicht, sondern ein Deepfake. (Foto: Undrey/Shutterstock)

Es ist bekannt, dass Fotos auf Social Media neben anderen Daten ohne Autorisierung verwendet werden, um KI zu trainieren. In einigen Ländern werden Social-Media-Posts auch genutzt, um Aktivisten zu verfolgen: In Russland wurden 2017 aufgrund eines Fotos 200 Oppositionelle und Unterstützer:innen von Alexej Nawalny festgenommen.

Tools wie Social Mapper (2018) oder FindFace (2017) gleichen Fotos mit Social-Media-Profilen ab und ordnen diese dann zu – das wurde in Russland genutzt, um eine Art Online-Pranger mit Demonstrationsteilnehmer:innen zu erstellen. Aber auch hierzulande hat die Bild-Zeitung eine Liste mit mutmaßlichen Vandalen des G-20-Gipfels veröffentlicht, zur Identifizierung wurden Fotos von Facebook und Twitter genutzt.

Dieses Problem soll durch eine Deepfake-KI behoben werden, deren Modell Umur Çiftçi und Gokturk Yuksek von der Binghamton University zusammen mit Ilke Demir von Intel Labs entwickelt haben. In einem ersten Paper, das noch zur Peer-Review aussteht, stellen sie ihr Konzept vor.

Subtile Gesichtsveränderung für mehr Privatsphäre

Im Paper „My Face My Choice: Privacy Enhancing Deepfakes for Social Media Anonymization“ wird mit My Face My Choice (MFMC) ein Modell vorgeschlagen, bei dem Gesichter dezent verändert werden. Geschlecht, Alter, Pose und Ethnizität bleiben erhalten, die Gesichtszüge werden unauffällig verändert. Diese Transformation geschieht über ArcFace, ein Projekt des Imperial College London. Der Fake sieht dabei dem Original ähnlich, ohne, dass reale Gesichtszüge für eine Gesichtserkennung nutzbar sind.

Nur die Person, die das Foto hochlädt, entscheidet, ob das eigene Gesicht im Foto angezeigt werden soll. Alle anderen, die ihr eigenes Gesicht zeigen möchten, müssen den oder die Ersteller:in bitten, ihr Gesicht zu entsperren. Wird eine Person getaggt, dient das als automatisches Entsperren. Wird der Tag entfernt, wird wieder ein Deepfake ausgespielt.

Ausspielung von Deepfakes auf Basis der Netzwerk-Graphen

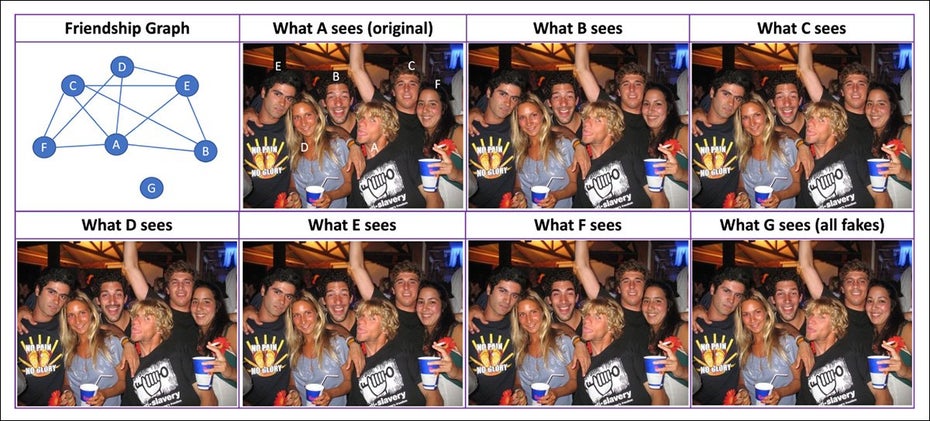

Nicht alle kriegen dabei Deepfakes ausgespielt – das hängt davon ab, wer das Foto aufruft. Die Deepfakes werden nämlich anhand des Netzwerk-Graphen ausgespielt: Ob das reale oder ein Fake-Gesicht angezeigt wird, hängt davon ab, ob die Konten miteinander verknüpft sind, beispielsweise durch Follows, Kontakte oder akzeptierte Freundschaftsanfragen. Gibt es beispielsweise ein Gruppenfoto, auf dem eine Person nur mit einer anderen verknüpft ist, wird sie ihr Gesicht und das der befreundeten Person sehen. Die anderen drei sind Deepfakes.

Auf Basis des Netzwerkgraphen werden Deepfakes oder echte Gesichter ausgespielt. (Bild: Bingham University, Intel)

Das Modell sollte, so wird explizit erwähnt, als Zusatz zu bestehenden sozialen Netzwerken genutzt werden – es sei keine Basis für eine neue Plattform.

Granulare Zugriffsrechte für das eigene Gesicht

Das Forschungsteam sieht das Modell nicht als extreme Lösung, sondern als Anwendung, um wirklich konkret die Zugriffsrechte bei Plattformen wie Facebook und Co wirklich durchzusetzen.

Die Argumentation ist: Wirkliches Interesse haben Menschen ohnehin eher nur an ihren Freund:innen, dementsprechend sollte es irrelevant sein, ob die Gesichter der anderen Personen verändert worden sind. Sollten die Personen von Interesse sein, würde sich die Person tendenziell mit ihnen vernetzen – und dann ohnehin die realen Gesichter sehen.

Scraper, die die Plattformrestriktionen umgehen konnten, können so aber öffentlich und private Fotos nicht verwenden, die nie für solche Zwecke freigegeben wurden. Auf der anderen Seite würden Bild-KI mit Gesichtern trainiert, die nicht existieren, was ein Vorteil für „fantasievolle“ Bildsynthesen sein könne.