Mit der Einführung von Mum wird sich die Google-Suche wahrscheinlich stark verändern. (Foto: Shutterstock/Jeramey Lende)

Google hatte Mum erst im Mai angekündigt. Wann das Update erfolgen würde, dafür gab es noch keine konkretere Zeitangabe als „in den kommenden Monaten und Jahren“. Bei Googles „Search On“-Event wurden jetzt erste Features vorgestellt, in welchen Mum in absehbarer Zeit zumindest teilweise bereits eingesetzt werden wird. Interessante Neuerungen gibt es vor allem in den Bereichen Shopping, Search und bei der Google Lens.

Mum steht in den Startlöchern

Google erklärt, das Sucherlebnis multimedial machen zu wollen. Dabei hilft Mum, das Multitask Unified Model, eine KI, die Sprache verstehen und generieren kann – besser als Bert. Da Mum multimodal ist, soll sie auch Bilder und in Zukunft Video- und Audiodateien verstehen. Erste Updates soll es in den „kommenden Monaten“ geben. Dann sollen Nutzer:innen innerhalb einer Suchanfrage Bild und Text kombinieren können: Wenn beispielsweise ein Bild eines gemusterten Hemds geöffnet ist, kann die Google Lens geöffnet werden. Mit dem ausgewählten Bildausschnitt und einer eingetippten Suchanfrage wie „Socken in diesem Muster“ werden dann das Bild, nämlich das Muster, und die Suchanfrage in Form von Text kombiniert. Ausgespuckt werden in dem Beispiel dann Shopping-Ergebnisse.

Das soll besonders deswegen hilfreich sein, weil viele Menschen nicht immer für alles die passende Bezeichnung parat haben – zum Beispiel wie das spezielle Blumenmuster genannt wird oder wie alle Einzelteile des Fahrrads heißen. Das führt Google als zweites Beispiel auf: Nutzer:innen können ein kaputtes Teil am Fahrrad mit der Google Lens fotografieren und eine Anfrage wie „wie repariere ich das“ eintippen. Die KI soll das beschädigte Teil erkennen, anhand der Suchanfrage die Intention verstehen und als Ergebnisse Ratgeber oder gar Videos für die Reparatur anzeigen. Mit der Integration der Google Lens in die Google App rechnen die Google-Experten im Zeitfenster von Q4 bis Q1.

Veränderungen in den Suchergebnisseiten

Auch die SERPs werden durch Mum grundlegend anders. Erste neue Features wurden im Livestream angekündigt – allerdings gibt es auch hier noch keine Zeitangabe zum Roll-out. Die erste Änderung ist im Grunde eine ausgebaute und verbesserte Version von „Ähnliche Fragen“ – Mum soll identifizieren können, wie Nutzer:innen Themen erschließen. Mum würde also auswerten, welche Themen die Suchenden zuerst am häufigsten interessieren. Suche jemand „Acrylmalerei“ seien es beispielsweise Tutorials und Anleitungen, verschiedene Stilrichtungen oder wie Farbkleckse weggeputzt werden können.

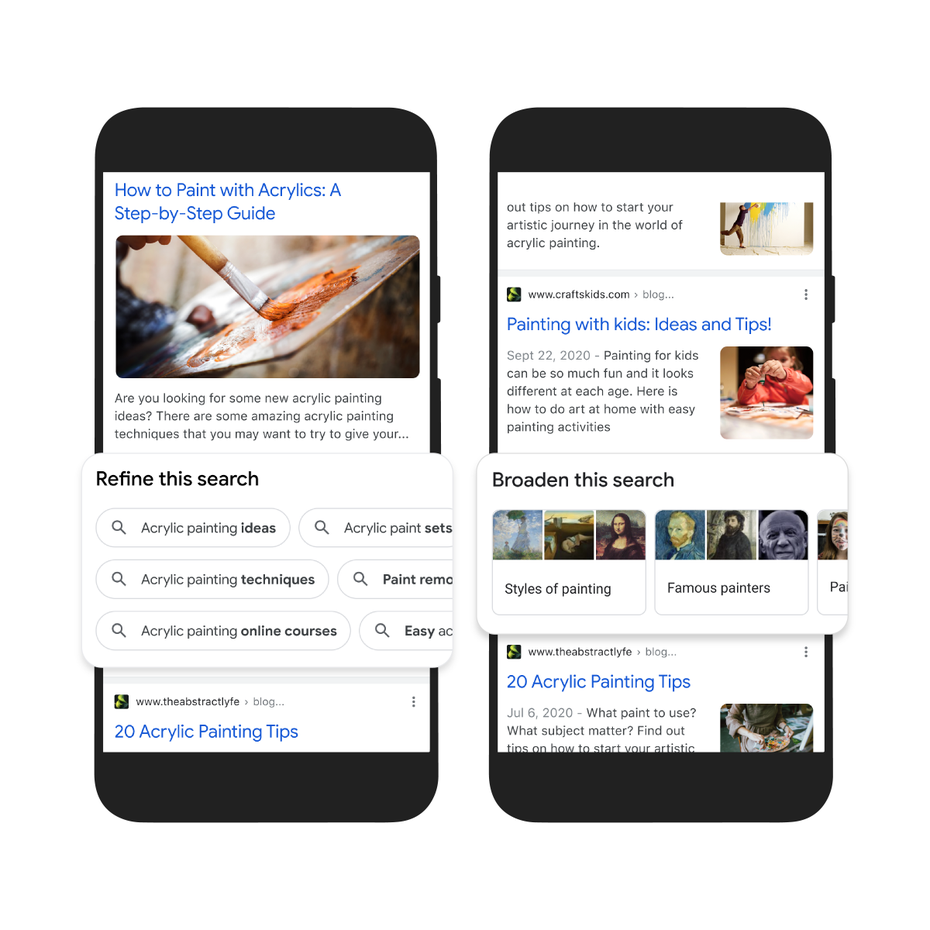

Dazu soll es die Möglichkeit geben, die Suche zu erweitern oder zu spezifizieren. Die Suchanfrage zu verfeinern, ist schon von den verwandten Suchanfragen am Ende der SERPs bekannt. Das Prinzip dabei ist bisher sehr einfach, hier werden quasi einfach Longtail-Keywords ausgegeben. Diese Box würde dann nicht ganz unten, sondern mitten auf der Seite erscheinen und wahrscheinlich feinere Suchanfragen ausspielen. Die andere Möglichkeit, die Suchanfrage zu verallgemeinern, würde dann Oberthemen anzeigen wie „Malerei“ oder „berühmte Maler“, wie im Beispiel zu sehen ist:

So sollen die Boxen für breitere oder genauere Suchbegriffe aussehen. (Bild: Google)

Zuletzt werden die Snippets der SERPs zusätzliche Informationen über den Herausgeber bieten. Dazu werden wohl einerseits eigene Informationen hinzugezogen, wie „Über Uns“-Seiten oder das Impressum, aber auch Bewertungen von anderen Organisationen oder Seiten. Damit wolle Google es User:innen noch einmal erleichtern, Quellen ohne großen Aufwand prüfen zu können. Auch ähnliche Suchergebnisse sollen dort angezeigt werden.

Shopping: Lokale Lagerbestände und Instagram-ähnliches Sofortshopping

Die Updates im Shopping-Bereich werden zunächst nur in den USA ausgerollt werden. Insgesamt wolle Google eine sehr visuelle Shopping-Suche schaffen. Google Lens soll in Zukunft auf Fotos abgebildete Produkte erkennen und anzeigen können. Dabei wird die Google Lens auf einer Website mit Fotos aktiviert, auf diesen erscheinen dann kleine Punkte. Diese markieren, wo ein Produkt erkannt wurde. Mit einem Tap darauf sollen dann Shopping-Ergebnisse angezeigt werden – das sieht dann fast so aus wie auf Instagram. Auch auf dem Desktop sollen Produkte mit der Google Lens anhand einer Bildersuche gesucht werden können. Die Produkte werden auf einem Overlay am Rand angezeigt.

Auch hier gibt es Änderungen in den SERPs – wird nach Produkten gesucht (wie „Crop Top“), werden auch vorrangig Produkte angezeigt sowie Läden, die diese verkaufen. Suchergebnisse, die keine Produkte oder Läden sind, beispielsweise Ratgeber, werden deutlich weniger ausgespielt.

Produkte selbst sollen künftig von Geschäften auch als vorrätig oder nicht vorrätig ausgezeichnet werden können. Hier gibt es noch keine weiteren Informationen, wie viel davon händisch geschehen muss, oder inwiefern das automatisiert wird oder werden kann – also ob diese Funktion überhaupt realistisch umsetzbar ist. Laut Google werde diese Funktion ab sofort in den USA und 14 weiteren Ländern ausgerollt.

Weiterführend Informationen zu Videos

Videos, die in den SERPs nicht direkt zu einer Website weiterleiten, sondern in den SERPs abgespielt werden, erhalten in Zukunft Buttons mit weiterführenden Themen und Suchanfragen. Mum soll in den Videos Themen identifizieren können, auch wenn die gar nicht explizit erwähnt werden. In Googles Beispiel werden zum Video über Pinguine Buttons zu weiteren Informationen über Pinguine, Robben und eine Insel angezeigt sowie verschiedene Suchanfragen wie „Macaroni Pinguine Lebenslauf“. Das wird so im Video nicht erwähnt, das Thema werde aber aus den gezeigten Informationen wie der Suche nach Familienmitgliedern und dem Umgang mit Raubtieren erschlossen. Diese Update soll in den kommenden Wochen starten, dafür soll es bald eine Opt-in-Möglichkeit geben.

Die sauber getrennten Bereiche werden anscheinend aufgelöst

In allen Beispielen von Google werden multimediale Suchergebnisse verschiedenster Google-Bereiche überall angezeigt: Shopping-Ergebnisse in der Google Lens und mehr Bilder, Videos und auch Shopping-Ergebnisse in der regulären Suche bis hin zu Overlays mit Produkten oder weiteren Informationen. Google scheint ein großes Ökosystem zu entwickeln, da sind getrennte Bereiche für eine Bildersuche oder eine Shopping-Suche wohl veraltet. Das soll nutzerfreundlicher sein: Niemand muss mehr genau wissen, wie die Dinge heißen, die man sucht – man kann mit Bildern und Fotos suchen und sich Ergebnisse in Text-, Video- oder Bildform ansehen. Die Multimedialität, möglich durch Mum, soll auch Sprachbarrieren vermindern oder umgehen. Es scheint aber auch so, als würden Informationen von ihren jeweiligen Erscheinungsorten getrennt. Informationen sollen User:innen überall jederzeit zur Verfügung stehen, was im Umkehrschluss aber auch bedeutet, dass sie eventuell stärker von Site zu Site springen. Während es also erst einmal aussieht, als würde der E-Commerce gewinnen, ist es für die Menschen aber auch deutlich einfacher, Preisvergleiche anzustellen und zum billigsten Anbieter zu gehen. Für die Suchmaschinenoptimierung bedeutet das wahrscheinlich auch bedeutende Änderungen – beispielsweise, was die Relevanz von Keywords und die erforderliche Qualität von Content angeht.